: هل ينجح محتوى الذكاء الاصطناعي في تصدر جوجل؟ إليك ما يبحث عنه المحرك فعلياً في 2026

هل يقضي الذكاء الاصطناعي على السيو أم ينقذه؟

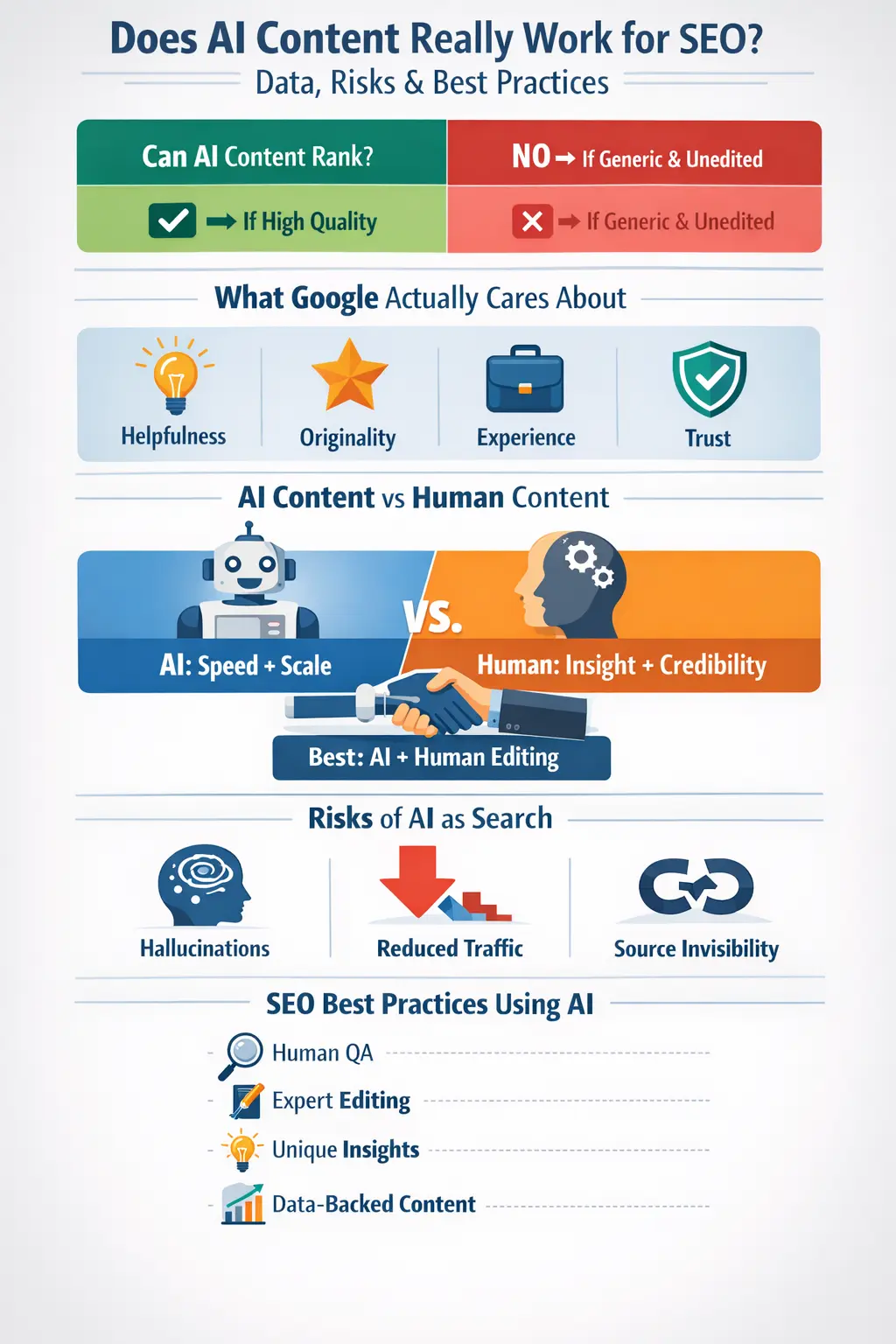

أثار المحتوى المولد بواسطة الذكاء الاصطناعي أكبر حالة جدل شهدتها ممارسات التسويق عبر محركات البحث مؤخراً. يرى المنتقدون أن هذه المواد تدمر السيو لأنها تنتج آلاف المقالات النمطية ضعيفة القيمة التي تملأ الإنترنت.

في المقابل، تعتقد مجموعة أخرى أن المحتوى المولد آلياً يحقق نتائج أفضل، ببساطة لأن الذكاء الاصطناعي قادر على إنتاج كميات ضخمة من المحتوى وتحسين أدائه بناءً على تحليل البيانات.

ما هو الوضع الحقيقي إذن؟

مع ظهور "نظرة جوجل العامة" (AI Overviews) والإجابات التوليدية، وبناءً على أنظمة الترتيب الجديدة، يجد صناع المحتوى والناشرون أنفسهم أمام نقطة تحول حاسمة بينما يتحَول جوجل إلى محرك بحث مدعوم بالكامل بالذكاء الاصطناعي.

السؤال الجوهري الذي نحتاج للبحث فيه هو: هل يثبت المحتوى المنتج لأغراض السيو كفاءته فعلياً عند التطبيق؟

هذا الأمر بات يهمنا اليوم أكثر من أي وقت مضى، خاصة في عالم "ما بعد الكوكيز" وظهور النتائج التوليدية؛ حيث تتقلص الزيارات، وتشتد المنافسة، وتصبح "الثقة" هي المعيار الحقيقي للتَّصدر.

في هذا الدليل، سنقوم بتحليل بيانات واقعية، ونستعرض موقف جوجل الرسمي، مع رصد لآراء خبراء السيو على منصة "ريديت" (Reddit)، لنكشف لك متى ينجح هذا المحتوى.. ومتى يفشل بشكل كارثي.

ما هو محتوى الذكاء الاصطناعي؟ وكيف نستخدمه اليوم؟

بشكل مبسط، تعتمد أدوات توليد المحتوى على نماذج لغوية ضخمة (LLMs) لإنتاج نصوص بناءً على كلمات مفتاحية وبيانات تدريبية معينة. أما عندما نتحدث عن "مولدات محتوى السيو"، فنحن نقصد أدوات تجمع بين ثلاثة أركان أساسية: البحث عن الكلمات المفتاحية، تحليل نتائج البحث (SERP)، وقدرات التحسين الفني للمَقالات.

اليوم، مصطلح "الذكاء الاصطناعي التوليدي" لم يعد يقتصر على كتابة فقرة أو اثنتين، بل أصبح يشمل كل شيء؛ بدءاً من المدونات وصفحات المنتجات، وصولاً إلى السيناريوهات ومنشورات التواصل الاجتماعي.

حالياً، يعتمد المسوقون على الذكاء الاصطناعي في:

- تدوين المقالات الطويلة.

- كتابة وصف المنتجات بدقة.

- تجهيز صفحات الهبوط (Landing Pages).

- بناء العناقيد المحتواه (Topic Clusters).

- تنفيذ استراتيجيات السيو البرمجي (Programmatic SEO) على نطاق واسع.

تشير أبحاث من DailyAI و ClickRank إلى أن أكثر من 70% من المسوقين الرقميين يدمجون الذكاء الاصطناعي في سير عملهم. كما تؤكد تقارير CopyDetect أن الناشرين يستخدمون هذه التقنيات لتسريع البحث والمسودات الأولية، لكنهم يصرون على وجود "لمسة تحرير بشرية" لضمان الجودة والتحكم في الأداء.

في الواقع، لم يعد الذكاء الاصطناعي مجرد "موضة" أو أداة غريبة؛ لقد أصبح جزءاً أصيلاً من خطوط الإنتاج في شركات البرمجيات، والوكالات الإعلانية، ومنصات التجارة الإلكترونية.

لكن يبقى السؤال الأهم: العبرة ليست في استخدامه، بل في "طريقة" هذا الاستخدام، فهي التي تحدد من سَيتصدر ومن سيتراجع.

هل يظهر محتوى الذكاء الاصطناعي في الصفحة الأولى؟ ماذا تٌظهر نتائج الأبحاث؟

بعيداً عن التوقعات، أثبتت التجارب الميدانية لعام 2026 أن المحتوى المولد آلياً قادر على المنافسة، لكن أداءه "مرهون" بمدى جودة التحرير.

أبحاث من جهات ثقة مثل DailyAI و WP Suites لم تترك مجالاً للتخمين، المحتوى المصنوع بالذكاء الاصطناعي قادر على المنافسة، لكن أداءه يتأرجح بناءً على جودة التحرير التي خضع لها.

ماذا تقول الأرقام فعلياً؟

- منصة ClickRank كشفت عن مفارقة واضحة؛ المقالات التي كتبها الذكاء الاصطناعي وعدّلها بشر حققت نمواً في الزيارات بنسبة وصلت إلى 45% مقارنة بالمقالات المكتوبة يدوياً بالكامل. يبدو أن التكنولوجيا تعطي دفعة قوية لو استخدمناها صح.

- أما Media Search Group، فقد وجدت أن المسودات الأولية التي يجهزها الـ AI تتأرشف في جوجل بسرعة أكبر من تلك التي يبدأها البشر من الصفر.

- في المقابل، جاءت صدمة من CopyDetect؛ المحتوى الآلي "الخام" الذي لم يلمسه بشر كان أداؤه ضعيفاً جداً، ببساطة لأنه كان يفتقر للخبرة والمصداقية ولم ينجح في جذب انتباه القراء.

نقاط قوة الذكاء الاصطناعي:

- السرعة: ينجز في دقائق ما قد يستغرق ساعات من البحث والكتابة.

- القدرة على التوسع: إنتاج كميات ضخمة من المحتوى دون تعب.

- تمييز الأنماط: بارع في تحليل ما يفضله جوجل وتكرار الهياكل الناجحة.

- الاتساق الهيكلي: يلتزم بترتيب العناوين والفقرات بشكل منطقي ومنظم.

نقاط قوة البشر:

- الرؤية المبنية على التجربة: وحدك من يملك قصصاً واقعية ودروساً مستفادة من "أرض المعركة".

- السرد القصصي الاستراتيجي: القدرة على صياغة محتوى يلمس مشاعر القارئ ويوجهه لاتخاذ قرار.

- فهم السياق: إدراك الفروق الدقيقة في المعنى التي قد تغيب عن الخوارزميات.

- المصداقية والثقة: القارئ في 2026 يبحث عن "إنسان" يثق في رأيه، وليس مجرد مخرجات آلية.

لماذا يسقط المحتوى الآلي "الخام" في اختبار جوجل؟ الإجابة تكمن في تلك الفجوات التي تتركها الخوارزميات خلفها. عندما تنشر ما يخرج من الأداة مباشرة، فأنت تخاطر بتقديم محتوى يعاني من:

- لغة باهتة: استخدام عبارات عامة ومكررة تفتقد للروح والتميز.

- تحليل سطحي: الاكتفاء بملامسة قشور المواضيع دون الدخول في التفاصيل التي تهم القارئ الذكي.

- هياكل رتيبة: تكرار نفس أسلوب بناء الجمل والفقرات مما يجعل القراءة تجربة مملة.

- معلومات مضللة: خطر الوقوع في فخ الحقائق القديمة أو الأرقام التي يخترعها الذكاء الاصطناعي (الهلوسة).

باختصار؛ يمكن لمحتوى الذكاء الاصطناعي أن يتصدر النتائج، لكن فقط عندما تتعامل معه كـ مساعد كتابة ذكي، وليس كبديل للعقل البشري.

موقف جوجل الرسمي من محتوى الذكاء الاصطناعي

حسمت جوجل الجدل ببيانات واضحة: الشركة لا تبيت النية لمعاقبة المواقع لمجرد أنها تستخدم الذكاء الاصطناعي. الأمر ليس "مطاردة" للتقنية، بل هو تدقيق في القيمة الناتجة عنها. باختصار، جوجل يقيم محتواك بناءً على ثلاثة معايير ذهبية: الجودة، الفائدة، ومدى الموثوقية.

إذا كنت تظن أن خوارزميات جوجل تبحث عن "بصمة الآلة" لخفض ترتيبك، فأنت مخطئ. هي تبحث عن "أثر المنفعة". جوجل صرحت علناً أن الأتمتة ليست عدوة للسياسات، طالما أنها لا تُستخدم للتلاعب بنتائج البحث أو إغراق الويب بمحتوى "غث" لا يسمن ولا يغني من جوع.

الخلاصة هنا: جوجل لا يهمه من أمسك بالقلم، بل يهمه ما كُتب. إذا كان محتواك المولد آلياً يساعد المستخدم ويحل مشكلته، فَجوجل سيرحب به.

بناءً على تحليلات Google Search Central ومنصة Social Press، لم يعد الأمر مجرد "تخمين"؛ أنظمة ترتيب النتائج في جوجل باتت تعتمد بشكل كلي على ثلاثة محاور لا يمكن تجاوزها:

- معايير E-E-A-T: وهي (الخبرة، التخصص، المصداقية، والثقة). جوجل يريد أن يعرف: هل كاتب هذا الكلام جربه فعلياً؟ و هل المصدر موثوق؟

- نظام المحتوى المفيد: النظام الذي يُفرق بين المقال المكتوب "لإرضاء المحرك" والمقال المكتوب "لخدمة الإنسان".

- خوارزميات كشف السبام: وهي خط الدفاع الأول ضد المحتوى الآلي الذي لا هدف له سوى حشو الكلمات.

جوجل واضحة جداً هنا: الأتمتة والذكاء الاصطناعي في حد ذاتهما ليسا ضد السياسات، لكن المحتوى الضعيف، غير المفيد، والمنتج بكميات ضخمة (Mass-produced) دون قيمة حقيقية، هو ما يضع موقعك في "القائمة السوداء".

بالممارسة العملية، ماذا يعني كل هذا الكلام؟ يعني أن جوجل فتح الباب أمام محتوى الذكاء الاصطناعي، لكنه وضع "فلتر" صارم جداً عند المدخل.

المعادلة أصبحت كالتالي:

- مسموح: استخدام الذكاء الاصطناعي كأداة مساعدة في الكتابة.

- ممنوع: المحتوى الآلي الضعيف، المضلل، أو الذي يفتقر للقيمة (Thin Content).

متى يمنحك جوجل "الضوء الأخضر" لتتصدر؟ إذا كان مقالك المولد بالذكاء الاصطناعي ينجح في:

- تقديم رؤية أصلية أو زاوية جديدة للموضوع.

- إظهار خبرة حقيقية (كأنك تتحدث عن تجربة واقعية).

- تقديم حلول فِعلية لمشاكل المستخدم.

- توفير قيمة مضافة لا يجدها القارئ في المواقع الأخرى.

أما إذا كان دور الذكاء الاصطناعي هنا هو مجرد "إعادة صياغة" لما قاله الآخرون دون أي تمييز، فاستعد للفشل. في 2026، جوجل سيتجاهل هذا النوع من المحتوى ولن يعطيه وزناً، وسواء كان الكاتب بشراً أو روبوتاً، النتيجة واحدة: لا ترتيب ولا زيارات.

حقيقة ما يحدث على "ريديت" ومجتمعات السيو

إذا أردت الحقيقة بدون تجميل، راقب ما يقوله محترفو السيو في "ريديت". هناك تظهر التجارب الحقيقية بعيداً عن التصريحات الدبلوماسية للشركات. من خلال مئات النقاشات، ظهرت أنماط واضحة لا يمكن تجاهلها:

ما الذي ينجح فعلياً؟

- بناء الهياكل (Outlines): استخدام الذكاء الاصطناعي لرسم خارطة طريق المقال وتوزيع العناوين.

- المسودات الأولية: الاعتماد على الآلة في كسر "قفلة الكاتب" وتجهيز المسودة الأولى.

- التحرير البشري: التدخل اليدوي لإعادة صياغة الجمل وإضافة الروح للنص.

- مراجعة الخبراء: التأكد من أن المعلومات دقيقة تقنياً وتناسب المتخصصين.

- الأمثلة الواقعية: إثراء المحتوى بقصص حقيقية ودراسات حالة (Case Studies) لا تعرفها الخوارزميات.

ما الذي يؤدي للسقوط الحر؟

- النشر الآلي الضخم (Bulk Publishing): إغراق الموقع بمئات المقالات المولدة آلياً في وقت قصير.

- الصفحات البرمجية المهملة: إطلاق صفحات (Programmatic SEO) دون أي إشراف تحريري أو لمسة بشرية.

- القوائم الجاهزة (Listicles): المقالات التي تسرد نقاطاً مكررة دون تقديم قيمة مضافة أو رأي خبير.

- التوسع بدون جودة: التركيز على الكمية (Scaling) مع غياب تام لعملية ضبط الجودة (QA).

يقول أحد مديري السيو المخضرمين:

"الذكاء الاصطناعي هو متدرب عبقري، لكنك لا تزال بحاجة إلى استراتيجي، ومحرر، وخبير متخصص ليُخرج العمل للنور بشكل صحيح."

بينما علق خبير آخر على تجربة قاسية مر بها:

"تصنيفات موقعنا انهارت تماماً عندما سمحنا للذكاء الاصطناعي بالنشر مباشرة دون تعديل. لم تعد النتائج للتحسن إلا بعد أن أضفنا طبقة التحرير البشرية فوق المحتوى الآلي."

الخلاصة واضحة للجميع: الذكاء الاصطناعي يحقق نتائج مذهلة عندما تقوده استراتيجية بشرية، بينما تفشل الأتمتة "الخام" باستمرار في الصمود أمام خوارزميات البحث.

هل أصبح محرك البحث بالذكاء الاصطناعي خطراً حقيقياً؟

صحيح أننا نستخدم أدوات الذكاء الاصطناعي يومياً لتحسين العمل، لكن الاعتماد عليه "كمحرك بحث" (Search Engine) يضعنا أمام تحديات لم تكن في الحسبان. مع انتشار Google AI Overviews ,Chat GPT، بدأنا نلاحظ ثغرات تقنية وأخلاقية تؤثر مباشرة على جودة الإنترنت الذي نعرفه.

- المعلومات المضللة (الموثوقية): أكبر مشكلة هي "الهلوسة". الروبوت أحياناً يؤلف معلومة خاطئة تماماً لكنه يكتبها بلهجة واثقة جداً. دراسات arXiv الأخيرة صادمة؛ معدل المعلومات المفبركة تصل لـ 27% في المواضيع المعقدة. تخيل حجم الضرر لو كان الموضوع طبياً أو قانونياً.

- من أين سَيأتي الزوار؟ الوضع أصبح مقلقا للناشرين. تقرير The Guardian الأخير يوضح أن ملخصات الذكاء الاصطناعي تسرق النقرات. في بعض المجالات، اختفى 60% من الترافيك لأن المستخدم يأخذ المعلومة من الملخص ويغلق الصفحة. هل سألنا أنفسنا: لو ماتت المواقع التي تمد الذكاء الاصطناعي بالبيانات، من أين سَيأتي بالمعلومات مستقبلاً؟

- اختفاء المصدر: المصدر الذي اختفى في الزحام ،الذكاء الاصطناعي "يستعير" مجهودك، يلخصه، ثم ينسى أن يذكر اسمك بوضوح. هذا يقتل "سلطة البراند" ويحرمك من الـ Citation Equity. بدون رابط مباشر وواضح، يذهب مجهود الكاتب الأصلي في ثوانٍ.

- التكلفة: التي لا يراها المستخدم خلف هذه الإجابات السريعة، هناك حواسيب تستهلك طاقة جبارة. الاستدامة البيئية أصبحت محل شك كبير في دراسات arXiv، لأن معالجة هذه البيانات (Inference) مكلفة جداً بيئياً ومادياً مقارنة بالبحث العادي.

- هل هي حقيقة أم مجرد "توقع إحصائي"؟ المستخدم اليوم تائه. هل هذه الإجابة حقيقة مثبتة أم مجرد كلمات رصّها النظام بناءً على "الاحتمالات"؟ غياب الشفافية هذا يجعلنا نراجع ألف مرة قبل أن نصدق أي معلومة تظهر لنا في واجهة البحث الجديدة.

ماذا يعني هذا لخبراء الـ SEO؟

باختصار، اللعبة تغيرت. هذا التحول يهدد الظهور المجاني (Organic visibility) وقدرتنا على تحقيق أرباح من المحتوى. لم يعد أمامنا خيار سوى:

- التمسك بـ "سلطة الموقع" (Organic Authority).

- بناء اسم تجاري قوي يبحث عنه الناس بالاسم لِيتجاوزوا فلاتر الروبوتات.

- تقوية إشارات الثقة (Trust Signals) في كل سطر نكتبه.

كيف تستخدم الذكاء الاصطناعي في السيو بدون ما تخاطر بموقعك؟

هنا النقطة التي تفصل بين المواقع التي تنجح والمواقع التي تختفي. السر هنا ليس في استخدام الأداة، السر في "طريقة العمل البشرية" التي تُدير الأداة. باختصار، الكتابة بالذكاء الاصطناعي الناجحة تعتمد على نظام صارم يبدأ وينتهي بلمسة بشرية.

خطوات العمل في أفضل وكالات السيو

حتى تخرج بمحتوى "محترم" وينافس فعلياً، يجب ان تتبع تسلسل واضح:

- خريطة الكلمات والنية (Intent Mapping): نبدأ بتحديد ما الذي يبحث عنه الباحث بالضبط؟ ليس فقط كلمات مفتاحية، بل ايضا ما هو الغرض من البحث.

- المسودة الأولية بالذكاء الاصطناعي: نستخدم الأدوات حتى نجهز الهيكل العام (Outlines) ونكتب مسودة أولية توفر علينا وقت العصف الذهني.

- التحرير المتخصص: هنا يتدخل "خبير الموضوع". وظيفته تصحيح المفاهيم وإضافة نكهة الخبرة.

- إضافة رؤية خاصة وأمثلة حية: الروبوت لم يجرب حل مشكلة تقنية ولم يتعامل مع عميل، أنت الذي يضيف هذه القصص والأمثلة الواقعية.

- دمج البيانات والمصادر: توثيق الأرقام والروابط الخارجية لمصادر موثوقة لرفع مصداقية المقال.

- المراجعة النهائية (QA): التأكد من أن النص "بشري" وسلس، ولا يحتوي كليشيهات الروبوتات المملة.

- التحسين التقني: ضبط الـ Metadata وتوزيع الكلمات المفتاحية بشكل طبيعي.

قائمة التحقق لضمان جودة المحتوى

قبل الضغط على زر "نشر"، مرر مقالك على هذه الفلاتر:

أولاً: جودة المحتوى

- هل المقال أجاب فعلاً على سؤال الباحث بصورة مباشرة وواضحة؟

- هل أضفت معلومة جديدة ليست موجودة في أول 10 نتائج بجوجل؟

- هل راجعت الحقائق والأرقام بنفسك؟

ثانياً: اللمسة البشرية

- هل يحتوي أمثلة من واقع العمل والتجربة؟

- هل القارئ يشعر أنه يتحدث مع "خبير" ام "روبوت"؟

- هل الكتابة موجهة للبشر فعلاً، أم فقط إرضاء الخوارزميات؟

ثالثاً: أساسيات السيو

- هل العناوين (H1, H2, H3) منظمة ومنطقية؟

- هل الكلمات المرتبطة بالموضوع (LSI) موجودة بشكل طبيعي؟

- هل الروابط الداخلية والخارجية موجودة في مكانها الصحيح بـ Anchor Text طبيعي (مثل : خدمات تسويق سيو)؟

رابعاً: الثقة والمصداقية

- هل اسم الكاتب وخبرته واضحة؟

- هل يحتوي مصادر وإحالات لمواقع قوية؟

- هل الإحصائيات محدثة (سنة 2026) وليست قديمة؟

نصيحة أخيرة: ابتعد تماماً عن النشر الضخم أو استخدام القوالب الجاهزة المكررة. الفرق الناجحة تعتبر ان الذكاء الاصطناعي "مسرع" للإنتاج، ليس "مصنع" محتوى معلب.

الخلاصة: الذكاء الاصطناعي مجرد أداة.. وليس استراتيجية

دعونا نضع النقاط على الحروف؛ المحتوى المولد آلياً يمكنه أن يتصدر نتائج البحث، وهذا يحدث فعلاً. لكنه أيضاً قد يسقط سقوطاً مدوياً إذا أُسيء استخدامه.

الحقيقة التي يجب أن يعرفها كل صاحب موقع هي أن محركات البحث لا تكافئ "الأتمتة"، بل تكافئ :

- القيمة الحقيقية،

- الخبرة الواقعية

- الثقة المتبادلة مع القارئ.

في 2026، الصيغة الوحيدة للنجاح هي: (ذكاء اصطناعي + خبرة بشرية + صرامة تحريرية).

لماذا نحتاج البشر في هذه المعادلة؟ الذكاء الاصطناعي يتفوق في السرعة، والبحث الأولي، وتجهيز المسودات. لكن العقل البشري هو الوحيد القادر على تقديم الرؤية التحليلية، وإصدار الأحكام، وإضافة لمسة الإبداع والمصداقية التي تجعل القارئ يثق فيما يقرأ.

مستقبل المحتوى: مستقبل المحتوى المولد بالذكاء الاصطناعي (AI generated content) ليس لمن ينشر كميات هائلة من المقالات، بل هو في توظيف خدمات السيو لنشر المحتوى الأكثر نفعاً، والأكثر دقة، والأقرب لاحتياجات البشر.

باختصار: استخدم التكنولوجيا لتسريع إنتاجك، ولكن لا تتركها تقود استراتيجيتك. اجعل التميز البشري هو "البصمة" التي تميزك في بحر من المحتوى الآلي المكرر.

نبذة عن الكاتب: لوفيتو نازاريث

لوفيتو نازاريث مستشار تسويق رقمي ومالك شركة بريسم. يمتلك الخبرة في مجال الإعلان والتسويق الرقمي على مدار العقدين الماضيين وعمل على إدارة الآلاف من الحملات الاعلانية وعمل على مساعدة الشركات على الحصول على ملايين الدولارات من العملاء المحتملين الجدد. نازاريث محب لرياضات المغامرة ومغني وكاتب أغاني. تابعوه عبر وسائل التواصل الاجتماعي على Lovetto Nazareth@

أضف تعليقك!

المدونات الأخيرة

: هل ينجح محتوى الذكاء الاصطناعي في تصدر جوجل؟ إليك ما يبحث عنه المحرك فعلياً في 2026

زيارات البوتات على موقعك: دليل التعامل مع الزيارات الوهمية (حظر أم مراقبة؟)

GEO و AEO و LLMO مقابل SEO: هل تغيّر تحسين محركات البحث فعلًا؟

الصفحات اليتيمة (Orphan Pages): الثغرات التقنية الخفية وكيفية معالجتها في الـ

الدعم

الهاتف: +971 55 850 0095

البريد الإلكتروني: sales@prism-me.com

الموقع: شركة بريزم لإدارة التسويق الرقمي ذ.م.م. برج لطيفة، مكتب رقم 604 - الجناح الغربي، مركز التجارة العالمي 1، شارع الشيخ زايد، دبي، الإمارات العربية المتحدة

الاشتراك

انضم إلى نشرتنا الإخبارية لتبقى على اطلاع على الميزات والإصدارات.

باشتراكك، فإنك توافق على سياسة الخصوصية لدينا وتمنح موافقتك لتلقي التحديثات من شركتنا.